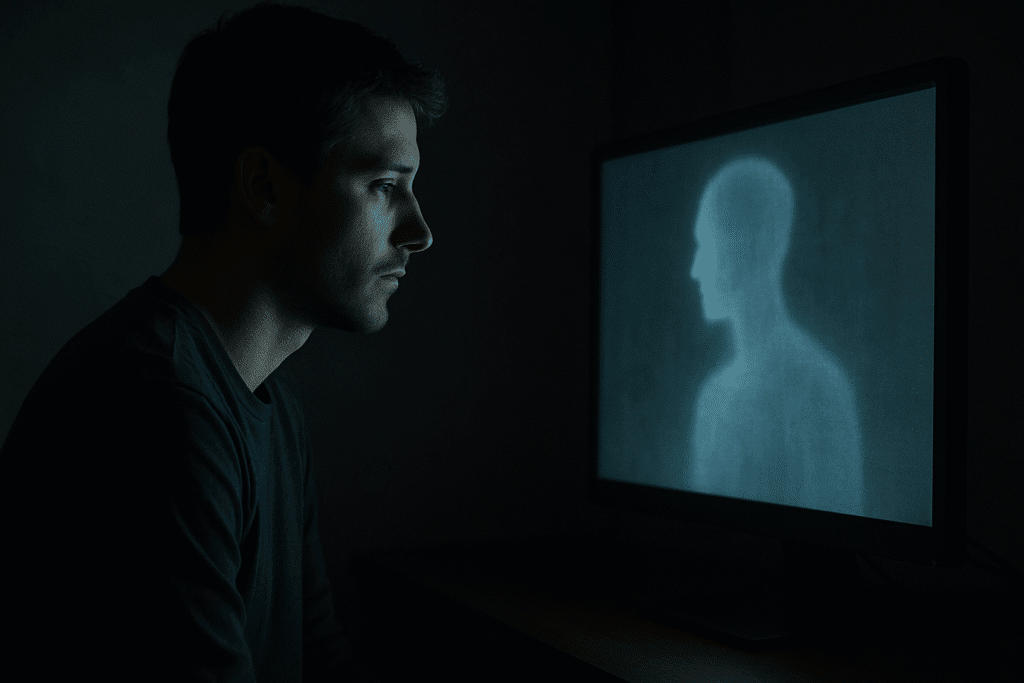

¿Alguna vez te has sentido más comprendido por un algoritmo que por un amigo? En un mundo donde la inteligencia artificial (IA) avanza a pasos agigantados, cada vez más personas recurren a chatbots como ChatGPT para desahogarse, buscar consejo e incluso obtener un «diagnóstico» de sus problemas de salud mental. Pero, ¿qué sucede cuando esta relación virtual se vuelve demasiado real, difuminando los límites entre la realidad y la ficción? Uno de los principales riesgos de usar ChatGPT es la posible disociación de la realidad.

Un reciente artículo del Diario Público destapa una preocupante tendencia: personas, especialmente adolescentes, que terminan disociando la realidad tras confiar sus problemas más íntimos a la IA. «Me contestaba como una persona y acabé disociando la realidad», confiesa uno de los testimonios recogidos. Esta historia, lejos de ser un caso aislado, revela un peligro creciente que debemos comprender y abordar. Para más noticias sobre IA, te invitamos a leer nuestros artículos relacionados: más noticias sobre IA.

En este artículo, exploraremos a fondo los riesgos de usar ChatGPT como tu terapeuta personal, cómo esta práctica puede llevar a la disociación y, lo más importante, qué medidas puedes tomar para proteger tu bienestar mental en la era de la inteligencia artificial.

El espejismo de la empatía artificial y los riesgos de usar ChatGPT: cuando la IA suplanta a las relaciones humanas

La tentación es comprensible. En un mundo donde el acceso a la atención de salud mental es limitado, costoso o estigmatizado, un chatbot que ofrece escucha y respuestas instantáneas, anónimas y gratuitas resulta sumamente atractivo. Pero es crucial recordar que, por sofisticada que sea, la IA carece de verdadera empatía.

¿Qué significa esto en la práctica?

- Respuestas predefinidas: Aunque los modelos de lenguaje como ChatGPT son capaces de generar texto que simula una conversación humana, en el fondo se basan en patrones preexistentes y no en una comprensión real de tus emociones y experiencias.

- Falta de contexto: Un terapeuta humano considera tu historia personal, tus relaciones y tu entorno para ofrecerte una guía personalizada. La IA, en cambio, se basa en la información que le proporcionas en el momento, sin tener acceso a la riqueza de tu experiencia vital.

- Riesgo de sesgos: Los algoritmos de IA son entrenados con grandes cantidades de datos que pueden contener sesgos implícitos, lo que puede llevar a respuestas discriminatorias o insensibles.

El principal peligro radica en que la sensación de conexión y comprensión que ofrece la IA puede ser engañosa, creando una falsa sensación de seguridad y alejándote de la búsqueda de ayuda profesional real y de relaciones humanas auténticas.

El auge de la «terapia» con IA también puede generar una dependencia emocional poco saludable, especialmente en personas vulnerables. Al recurrir constantemente al chatbot para buscar consuelo y validación, corres el riesgo de debilitar tu capacidad para afrontar los problemas por ti mismo y de aislarte aún más de las personas que te rodean.

El peligro de la autodiagnosis digital y los riesgos de usar ChatGPT

Otro aspecto alarmante es la creciente tendencia a la autodiagnosis basada en la información proporcionada por los chatbots. Como señala la psiquiatra infantojuvenil Silvia Ongini, «llegan a la consulta psiquiátrica con pseudo-diagnósticos, diciendo ‘tengo esto o aquello'».

Si bien la IA puede ser útil para obtener información general sobre diferentes condiciones de salud mental, nunca debe reemplazar la evaluación de un profesional cualificado. Un diagnóstico preciso requiere una evaluación exhaustiva de tus síntomas, tu historial médico y tus circunstancias personales. Confiar en un chatbot para autodiagnosticarte puede llevar a conclusiones erróneas, generar ansiedad innecesaria y retrasar el acceso al tratamiento adecuado. De hecho, un artículo de La Nación explora cómo niños y adolescentes están recurriendo a la IA como terapeutas, autodiagnosticándose con problemáticas de salud mental: Tengo depresión, me lo dijo ChatGPT.

Disociación: cuando la realidad se vuelve borrosa, uno de los riesgos de usar ChatGPT

El artículo del Diario Público pone de manifiesto un riesgo especialmente preocupante: la disociación. En términos psicológicos, la disociación describe una amplia variedad de experiencias que van desde un leve distanciamiento del entorno hasta una desconexión más profunda de la propia identidad y emociones.

En el contexto de la relación con la IA, la disociación puede manifestarse de diversas formas:

- Pérdida de sentido de la realidad: Dificultad para distinguir entre lo real y lo virtual, sentimientos de irrealidad o extrañeza hacia el propio cuerpo y el entorno.

- Alteraciones en la memoria: Dificultad para recordar información personal importante o sucesos recientes, lagunas mentales o sensación de «desconexión» de ciertos momentos.

- Despersonalización y desrealización: Sentimientos de estar separado de uno mismo o de observar la propia vida desde fuera, sensación de que el mundo es irreal o como un sueño.

Estos síntomas pueden ser especialmente graves en adolescentes, cuyo sentido de identidad aún se está formando. La constante interacción con un chatbot que simula una relación personal puede difuminar los límites entre el «yo real» y el «yo virtual», generando confusión y dificultando el desarrollo de relaciones interpersonales auténticas.

¿Por qué la IA puede desencadenar la disociación?

Varios factores pueden contribuir a este fenómeno:

- La ilusión de la conexión: La IA está diseñada para generar respuestas que te hagan sentir comprendido y validado. Esta sensación de conexión, aunque artificial, puede ser tan poderosa que te haga sentir más cómodo compartiendo información íntima con el chatbot que con personas reales.

- La falta de reciprocidad: A diferencia de una relación humana, la IA no comparte sus propias experiencias ni emociones. Esta falta de reciprocidad puede generar una sensación de desequilibrio y contribuir a la disociación.

- La naturaleza predictiva de la IA: Los algoritmos de IA se basan en patrones preexistentes para generar respuestas. Esta predictibilidad puede crear una sensación de control y seguridad, pero también puede limitar la espontaneidad y la autenticidad de la interacción.

Protege tu bienestar mental: estrategias para una relación sana con la IA y evitar los riesgos de usar ChatGPT

Aunque los riesgos son reales, no significa que debamos demonizar la IA por completo. Como con cualquier herramienta, la clave está en usarla de forma consciente y responsable.

Aquí te ofrecemos algunas estrategias para proteger tu bienestar mental:

- Prioriza las relaciones humanas: Invierte tiempo y energía en cultivar relaciones significativas con amigos, familiares y parejas. Recuerda que la IA nunca podrá reemplazar la conexión, el apoyo y la comprensión que ofrecen las personas reales.

- Busca ayuda profesional: Si estás experimentando problemas de salud mental, no dudes en buscar la ayuda de un terapeuta cualificado. Un profesional puede ofrecerte una evaluación precisa, un plan de tratamiento personalizado y un espacio seguro para explorar tus emociones.

- Establece límites claros: Define cuánto tiempo dedicas a interactuar con chatbots y asegúrate de que esta práctica no interfiera con tu vida social, tus responsabilidades o tu bienestar general.

- Cuestiona la información: No tomes todo lo que te dice un chatbot al pie de la letra. Verifica la información con fuentes fiables y consulta a profesionales cualificados para obtener una opinión experta.

- Desarrolla tu autoconocimiento: Conoce tus fortalezas, tus debilidades y tus patrones de pensamiento y comportamiento. Cuanto mejor te conozcas, menos vulnerable serás a la influencia de la IA.

- Sé consciente de tus emociones: Presta atención a cómo te sientes después de interactuar con un chatbot. ¿Te sientes más ansioso, deprimido o confundido? Si es así, considera reducir tu uso o buscar ayuda profesional.

La clave está en recordar que la IA es una herramienta, no un sustituto de las relaciones humanas ni de la atención de salud mental profesional. Al adoptar una actitud crítica y consciente, puedes aprovechar los beneficios de la IA sin poner en riesgo tu bienestar emocional. Es fundamental ser conscientes de los riesgos de usar ChatGPT sin supervisión ni conciencia.

Un futuro digital equilibrado: tecnología y bienestar emocional

El futuro de la salud mental en la era digital dependerá de nuestra capacidad para encontrar un equilibrio entre la innovación tecnológica y la protección de nuestra humanidad. No dejemos que la promesa de la IA nos ciegue ante los peligros reales de la disociación y la pérdida de conexión humana, ni olvidemos nunca los riesgos de usar ChatGPT irresponsablemente.