Meta Compute: La colosal apuesta de 600.000 millones con la que Zuckerberg redefine la infraestructura de IA

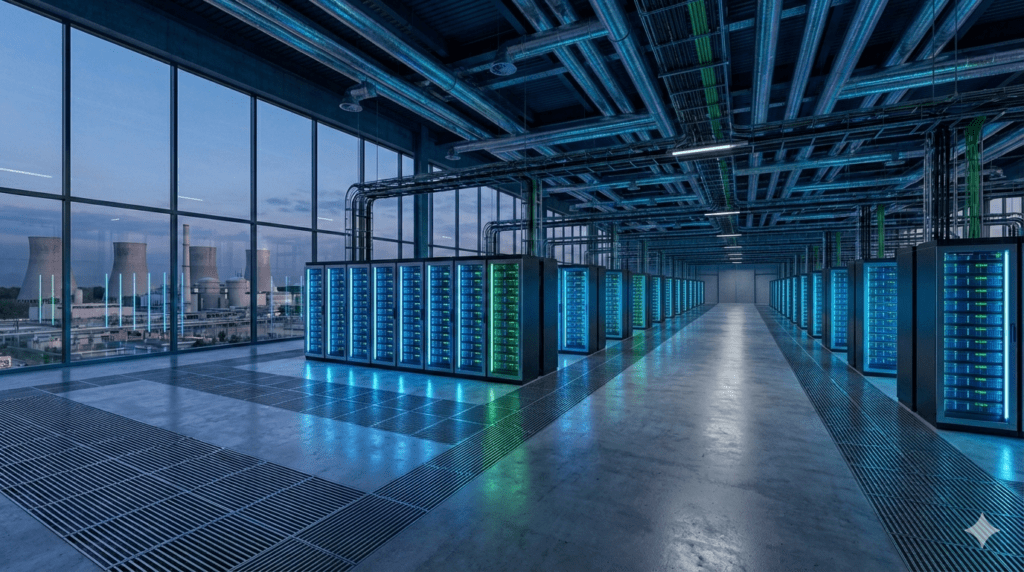

Recientemente, el panorama tecnológico global ha presenciado un movimiento sísmico. Mark Zuckerberg ha desvelado «Meta Compute», una iniciativa estratégica de alto nivel diseñada para centralizar y escalar drásticamente la infraestructura de Meta Compute inteligencia artificial. Lejos de ser una simple actualización de servidores, este anuncio marca el inicio de una carrera industrial sin precedentes. El objetivo declarado es ambicioso: alcanzar una capacidad de cómputo medida en «decenas de gigavatios en esta década y cientos con el tiempo».

Esta nueva dirección no es retórica. Se sustenta en un plan de inversión confirmado que asciende a 600.000 millones de dólares en infraestructura dentro de Estados Unidos hasta 2028. En la actualidad, esta cifra representa uno de los compromisos de capital más grandes en la historia corporativa moderna, con el fin último de asegurar la independencia tecnológica. Fuente oficial.

Una reorganización estratégica para Meta Compute inteligencia artificial

La creación de esta división implica una reestructuración fundamental en la cúpula de la compañía. Mark Zuckerberg ha asumido la supervisión directa de la iniciativa, elevándola a una prioridad absoluta. Para ejecutar la visión de Meta Compute inteligencia artificial, se ha conformado un triunvirato de liderazgo especializado:

- Santosh Janardhan estará al frente de la arquitectura técnica, abarcando desde el diseño de centros de datos hasta el desarrollo de silicio propio y el stack de software.

- Daniel Gross dirigirá la estrategia de capacidad a largo plazo, proyectando las necesidades de la empresa a 5 y 10 años vista.

- Dina Powell McCormick, en un rol crucial, gestionará las relaciones con gobiernos y entidades soberanas. Su misión es asegurar los vastos recursos energéticos y de suelo necesarios.

Del Megavatio al Gigavatio: Un salto de escala

Históricamente, los centros de datos se han medido en megavatios (MW). Sin embargo, Meta propone un cambio de paradigma hacia la escala de gigavatios (GW). Para ponerlo en perspectiva, un solo gigavatio puede abastecer de energía a aproximadamente 750.000 hogares. La ambición de Meta de gestionar «cientos de gigavatios» a largo plazo implica un consumo energético comparable al de países enteros industrializados.

La inversión en Meta Compute inteligencia artificial: ¿En qué se gasta?

El compromiso financiero acumulativo para el periodo actual y hasta 2028 es monumental. El gasto de capital (CAPEX) de la empresa ya ha experimentado un crecimiento notable, pero la nueva hoja de ruta acelera esta tendencia. Los fondos para potenciar Meta Compute inteligencia artificial se destinarán a cuatro pilares fundamentales:

- Construcción de nuevos Data Centers: Instalaciones optimizadas específicamente para cargas de trabajo de IA, alejándose de los diseños genéricos.

- Infraestructura Energética: Acuerdos para el suministro de energía nuclear y gas natural, vitales para garantizar una operatividad 24/7 sin depender exclusivamente de redes públicas saturadas.

- Adquisición de GPUs: Compra masiva de procesadores NVIDIA (H100 y futuros Blackwell).

- Producción de Silicio Propio: Desarrollo y fabricación a escala de los chips MTIA.

Deep Dive Técnico: Hardware y Soberanía del Silicio

Meta está ejecutando una transición desde una infraestructura de nube generalista hacia una maquinaria de IA altamente especializada.

Grand Teton: La evolución del servidor

La joya de la corona en el hardware de Meta es la plataforma «Grand Teton». Sucesora de la arquitectura «Zion-EX», este diseño integra múltiples chasis en una sola unidad monolítica. Esta ingeniería ofrece ventajas críticas:

- Mejora drásticamente la refrigeración líquida y por aire.

- Ofrece el doble de ancho de banda de red que su predecesor.

- Cuadruplica el ancho de banda entre el host y los aceleradores.

Basado en la filosofía del Open Compute Project (OCP), Grand Teton permite a Meta desplegar clusters masivos. Recientemente, se han confirmado configuraciones que superan las 24.000 GPUs H100 trabajando al unísono para el entrenamiento de modelos como Llama 3.

MTIA: Rompiendo la dependencia de NVIDIA

Para mitigar los costes y reducir la dependencia externa, Meta ha acelerado su programa de silicio personalizado: el Meta Training and Inference Accelerator (MTIA).

- MTIA v1: Lanzado anteriormente con tecnología de 7nm, sirvió como prueba de concepto para inferencia básica.

- MTIA v2: En la actualidad, este chip fabricado en 5nm por TSMC es el caballo de batalla para la inferencia. Es tres veces más rápido y 1.5 veces más eficiente que la primera versión.

Actualmente, MTIA gestiona la inferencia de los algoritmos de recomendación. Esto libera a las costosas GPUs de NVIDIA para concentrarse exclusivamente en el entrenamiento de los grandes modelos de lenguaje (LLMs).

Meta frente a Microsoft y Google: La guerra de los gigantes

El anuncio subraya una realidad ineludible: el factor limitante ya no es solo la disponibilidad de chips, sino la energía. La estrategia difiere significativamente de sus rivales:

- Microsoft / OpenAI: Su proyecto «Stargate» busca construir una única supercomputadora de 5 GW para 2028-2030. Meta, en cambio, apuesta por una capacidad agregada mucho mayor distribuida en múltiples nodos.

- Google: Posee una ventaja histórica gracias a sus TPUs y control vertical. Meta utiliza un enfoque híbrido: silicio propio para inferencia y hardware de NVIDIA para entrenamiento, apoyado por la ventaja táctica del código abierto.

Si quieres profundizar en las últimas novedades del sector, Sigue leyendo aquí.

Hacia la Superinteligencia Personal

La iniciativa no es simplemente una actualización de TI; es una declaración geopolítica y corporativa. La inversión de 600.000 millones de dólares conlleva un riesgo financiero extremo, pero la visión es clara. Zuckerberg no solo busca entrenar un modelo más inteligente, sino construir la infraestructura física necesaria para alojar una «Superinteligencia Personal» para miles de millones de usuarios. Esta es una carga computacional que ninguna nube actual podría soportar, y Meta Compute inteligencia artificial es la respuesta para hacerla viable en la próxima década.